Redação do Site Inovação Tecnológica - 21/01/2013

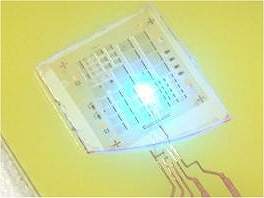

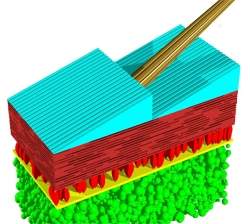

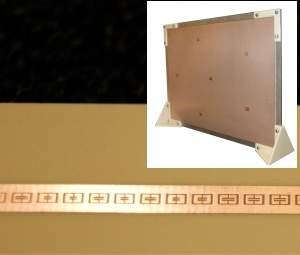

Na parte inferior, a linha de "antenas" que compõem o sensor. No detalhe, o sensor completo, formado por várias linhas. [Imagem: John Hunt/Duke ECE]

Compressão por hardware

Poucas tecnologias fizeram tanto sucesso e duraram tanto quanto a compressão de imagens JPEG, que ainda continua em seus melhores dias.

Mas que tal dispensar totalmente a necessidade de compressão das imagens sem lotar rapidamente seus cartões de memória e seus HDs?

John Hunt e seus colegas da Universidade de Duke, nos Estados Unidos, fizeram bem mais do que isso.

Eles criaram um mecanismo que permite que a imagem seja comprimida enquanto está sendo captada, ou seja, não se trata de comprimir o arquivo, mas algo mais parecido com "comprimir a cena" que o sensor está captando.

Tudo é feito com um tipo especial de lente, um dispositivo que não apenas dispensa a lente tradicional da câmera, mas dispensa também mecanismos mecânicos, como o obturador da máquina, e até mesmo o CCD, o sensor de imagem das câmeras digitais.

Sensor de antenas

Hunt fez essa aparente mágica usando os mesmos metamateriais usados nosmantos de invisibilidade.

Os metamateriais são materiais artificiais projetados para terem propriedades não encontradas em materiais naturais - mais especificamente, propriedades especiais na forma como eles lidam com a luz.

A metalente em si é um fino laminado com linhas formadas por pequenos quadrados de cobre, que funcionam como antenas, cada uma ajustada para um diferente comprimento de onda da luz.

Cada antena capta uma faixa de frequência, o que significa que o sensor obtém uma imagem muito mais detalhada da cena - sem precisar de lentes comuns, posicionadores mecânicos, sistemas de armazenamento ou mesmo programas para comprimir os arquivos.

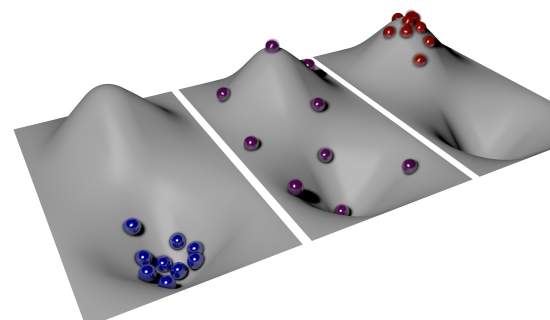

Isto porque, ao contrário dos sistemas atuais, o novo sistema não se preocupa em manter a dimensão da imagem (o número de pixels), mas trabalho para preservar o conteúdo de informação encontrado na cena, evitando capturar pontos adjacentes que não acrescentam informação sobre cada objeto em particular.

O resultado é uma compressão de imagem no próprio hardware, mais especificamente, no próprio sensor.

Como coleta a informação das cenas de forma mais eficiente do que os sensores de imagens tradicionais, os pesquisadores afirmam que o sensor de metamaterial permitirá que câmeras, sensores de raios X e outras tecnologias de imageamento capturem as imagens de forma mais rápida e usando equipamentos mais simples.

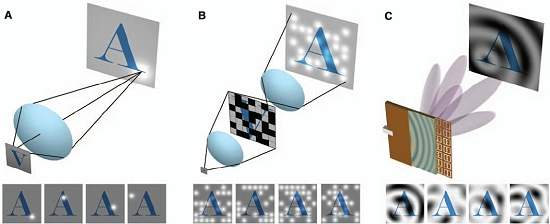

Diferença de funcionamento dos CCDs tradicionais (a), de um sistema de pixel único (B) e do novo sensor baseado em metamaterial, que faz amostragens da cena de forma similar a um holograma. [Imagem: John Hunt/Duke ECE]

Das micro-ondas para a luz visível

O protótipo de demonstração mostrou que o metassensor é capaz de capturar as imagens e reconstruí-las no computador com uma velocidade suficiente para mostrar filmes em tempo real, sem qualquer necessidade de pós-compressão.

Segundo os pesquisadores, o material é flexível e durável o bastante para ser grudado sobre uma parede, envolto em torno de cantos ou mesmo posto no chão como um tapete, o que o torna uma alternativa barata para uma grande variedade de aplicações de sensoriamento, como sistemas de segurança em aeroportos.

Claro que, como conceito inovador, o protótipo ainda não está pronto para substituir sua câmera digital: ele faz imagens bidimensionais e funciona apenas na faixa das micro-ondas.

O próximo passo é miniaturizar o sensor, construindo antenas com dimensões nanométricas, para que o sensor possa captar a luz visível.

Bibliografia:

Metamaterial Apertures for Computational Imaging

John Hunt, Tom Driscoll, Alex Mrozack, Guy Lipworth, Matthew Reynolds, David Brady, David R. Smith

Science

Vol.: 339 - pags. 310-313

DOI: 10.1126/science.1230054

Metamaterial Apertures for Computational Imaging

John Hunt, Tom Driscoll, Alex Mrozack, Guy Lipworth, Matthew Reynolds, David Brady, David R. Smith

Science

Vol.: 339 - pags. 310-313

DOI: 10.1126/science.1230054

Fonte: Inovação Tecnológica