Redação do Site Inovação Tecnológica - 13/12/2016

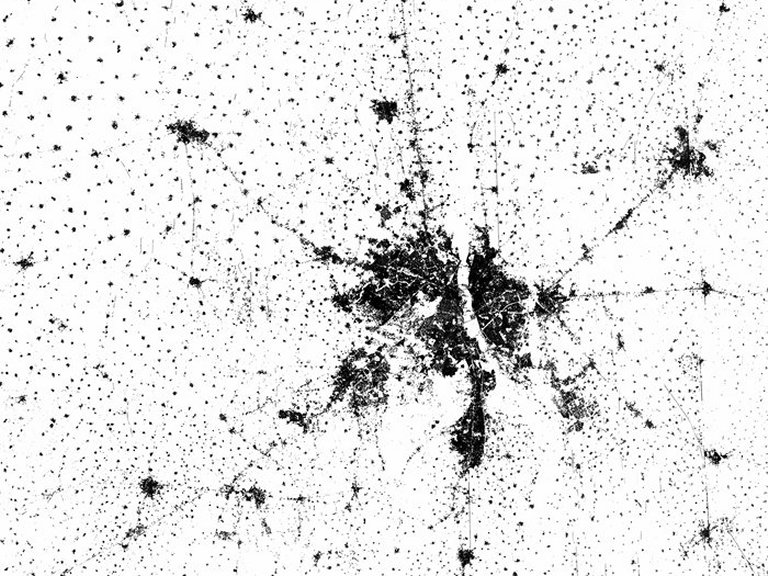

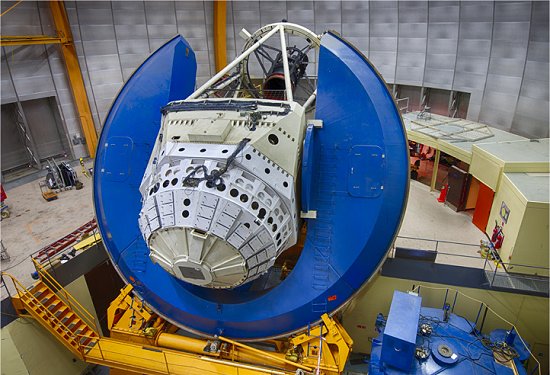

A supercâmera DECam foi projetada para procurar indícios da energia escura, mas está tendo mais sucesso localizando "matéria comum pouco brilhante".[Imagem: Reidar Hahn/DES]

Anão Distante

Acaba de ser descoberto um novo planeta anão, localizado 92 vezes mais longe do Sol do que a Terra - isto é mais do que o dobro da distância de Plutão.

A equipe vinha chamando o corpo celeste recém-descoberto de DD (sigla para Distant Dwarf, ou "anão distante"), mas agora ele passa a ser conhecido como 2014 UZ224.

O UZ224 leva mais de 1.100 anos para completar uma órbita em torno do Sol, sua luz leva 12 horas e meia para chegar até nós e é atualmente o segundo objeto mais distante conhecido no Sistema Solar.

Os astrônomos estimam que o planeta anão é redondo porque ele tem um diâmetro estimado em 560 quilômetros, o que significa que ele provavelmente tem massa suficiente - e, portanto, força gravitacional suficiente - para ser esférico. Dados adicionais, que estão sendo coletados por radiotelescópios, deverão ajudar a determinar o tamanho do novo planeta anão com maior precisão.

O UZ224 é um dos muitos pequenos mundos gelados que se encontram além do planeta mais distante do Sistema Solar, Netuno. Esses corpos celestes são chamados de Objetos TransNetunianos, ou TNOs - o mais famoso deles é o planeta anão Plutão.

Corpos escuros

O que mais chamou a atenção, contudo, foi o instrumento que os alunos do professor David Gerdes, da Universidade de Michigan, nos EUA, usaram para detectar o novo planeta anão: a supercâmera DECam, usada pelo projeto DES (Dark Energy Survey) para procurar indícios da Energia Escura.

A colaboração DES usa esta câmera, montada em um telescópio no Chile, para mapear galáxias distantes em busca de supernovas e para procurar padrões na estrutura cósmica. O objetivo é encontrar alguma explicação para a hipotética substância misteriosa que estaria acelerando a expansão do Universo.

Os objetos transnetunianos não estão entre os principais interesses científicos da DES, uma vez que eles não nos dizem nada sobre a expansão do Universo. Mas, como não dá para dizer à câmera para não registrar outros corpos celestes em seu campo de visão, ela acabou se transformando em um instrumento importante também para a astronomia.

"Até agora, descobrimos mais de 50 novos TNOs em nossos dados. O DD é o maior e o mais distante," disse Gerdes.

Planeta 9

A descoberta do DD coloca a DECam definitivamente no páreo em busca do Planeta 9.

O Planeta 9 é um ainda hipotético nono planeta na borda do Sistema Solar, com 10 vezes a massa da Terra, que seria a causa dos padrões inexplicáveis nas órbitas de vários TNOs.

Fonte: Inovação Tecnológica